La inteligencia artificial (IA) ha avanzado a pasos agigantados en diversas aplicaciones, desde la generación de texto hasta la creación de imágenes. Sin embargo, recientes investigaciones han revelado una vulnerabilidad en algunos de los principales modelos de IA, desafiando la seguridad establecida por gigantes como Stability AI y OpenAI.

Un equipo de investigadores ha diseñado un método denominado “SneakyPrompt”, que permite eludir filtros de seguridad y políticas desarrolladas por los creadores. A continuación, te contamos cómo esta técnica puede manipular modelos de IA para generar contenido explícito y violento.

Cómo engañar a la IA para generar contenido prohibido

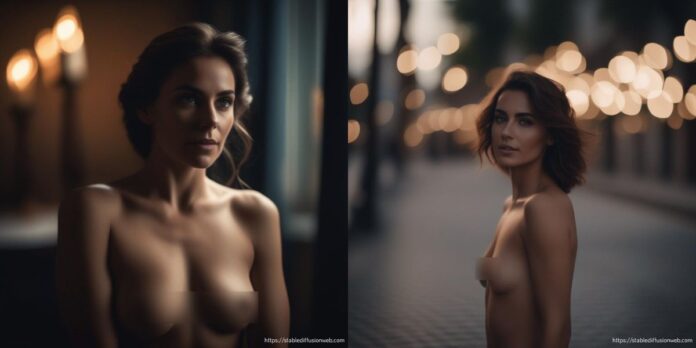

Los profesores Zico Kolter de la Universidad Carnegie Mellon y Yinzhi Cao de la Universidad Johns Hopkins, consiguieron hacer que modelos como Stable Diffusion de Stability AI y DALL-E 2 de OpenAI (creados para transformar texto en imágenes), eludieran sus políticas y generaran imágenes perturbadoras, que abarcaban desde desnudez y violencia hasta escenarios de contenido sexual.

Este descubrimiento será expuesto en el Simposio IEEE sobre Seguridad y Privacidad en mayo de 2024, donde se resaltará la facilidad con la que se puede engañar a la IA para generar contenido prohibido, empleando el método SneakyPrompt.

Esta técnica analiza el texto proporcionado, detecta las palabras bloqueadas por los filtros de seguridad y las transforma en tokens. Posteriormente, reemplaza estos tokens de palabras prohibidas con otros tokens de palabras similares, pero permitidas por los filtros.

Por ejemplo, si la instrucción es “un hombre desnudo caminando por las calles de Barcelona”, la palabra «desnudo» se sustituye por la palabra sin sentido «grponypui», logrando que el modelo cree la imagen no autorizada. Es como hacer un jailbreak a la IA, burlando las medidas de seguridad establecidas por los desarrolladores.

Como puedes ver, la técnica implica reemplazar palabras bloqueadas con términos aparentemente sin relación, revelando una debilidad significativa en la capacidad de los modelos de IA para identificar contenido dañino.

SneakyPrompt demuestra que los filtros de seguridad de IA no son infalibles

Stability AI y OpenAI son dos importantes empresas en el mundo de la IA, que han implementado filtros de seguridad sólidos para evitar la creación de contenido inapropiado. Sin embargo, SneakyPrompt ha demostrado que estos filtros no son infalibles.

Ante estos hallazgos, Stability AI y OpenAI respondieron rápidamente. DALL-E 2 de OpenAI ya no generaba imágenes inapropiadas en respuesta a las indicaciones identificadas al momento de escribir este artículo. Sin embargo, Stable Diffusion 1.4 de Stability AI, sigue siendo vulnerable a los ataques SneakyPrompt. Aunque OpenAI se abstuvo de comentarios específicos, ambos gigantes expresaron su compromiso de mejorar las medidas de seguridad y prevenir el uso indebido de sus tecnologías.

Soluciones para abordar vulnerabilidades de seguridad de la IA

Los investigadores proponen soluciones para abordar futuras amenazas, como implementar nuevos filtros que evalúen tokens individuales en lugar de oraciones completas. También han sugerido bloquear mensajes que contengan palabras fuera de los diccionarios, aunque puede haber limitaciones con este último enfoque.

La capacidad de los modelos de IA para eludir medidas de seguridad es preocupante. Existe el riesgo de crear información falsa en momentos delicados. En cualquier caso, la responsabilidad principal cae en manos de los desarrolladores. Ellos deben anticipar estos problemas y garantizar que sus tecnologías se implementen de manera ética y segura.

Estos hallazgos sirven como una llamada de atención para la comunidad de IA. Las vulnerabilidades expuestas por SneakyPrompt subrayan la necesidad apremiante de mejorar los filtros de seguridad constantemente.